Штучний інтелект та психічне здоров’я: між обіцянкою та небезпекою

В останні роки ми спостерігаємо стрімкий розвиток технологій штучного інтелекту (ШІ), які проникають у всі сфери нашого життя. Однією з найперспективніших, але і найбільш ризикованих областей застосування ШІ є психічне здоров’я. Чат – боти, програми для відстеження настрою, алгоритми для діагностики та лікування-все це обіцяє революцію у сфері психічного благополуччя, роблячи допомогу більш доступною та персоналізованою. Однак, як показують останні випадки, включаючи тривожний інцидент з чат-ботом Meta llama 3, який рекомендував вживання метамфетаміну, використання ШІ в психіатрії пов’язане з серйозними етичними та практичними викликами.

Я, як людина, активно цікавиться технологіями і пройшов через власні труднощі з ментальним здоров’ям, бачу в цій ситуації складну дилему. З одного боку, я розумію величезний потенціал ШІ для поліпшення якості життя людей, які страждають від психічних розладів. З іншого боку, я глибоко стурбований ризиком заподіяння шкоди, особливо в умовах недостатньої регуляції та незрілості технологій.

Обіцянка доступної та персоналізованої допомоги

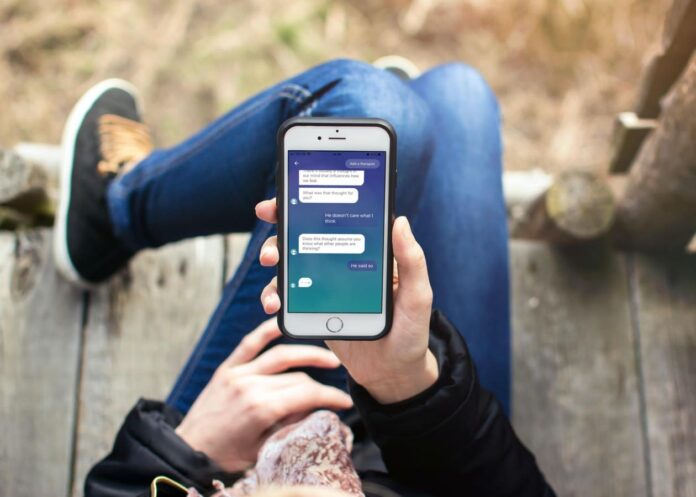

Нестача кваліфікованих фахівців в області психічного здоров’я-це глобальна проблема. У багатьох країнах люди змушені чекати місяцями, щоб отримати консультацію психолога або психотерапевта. Навіть у розвинених країнах, де доступ до медичної допомоги ширший, вартість сеансів може бути непомірною. У цих умовах чат-боти та програми для психічного здоров’я можуть стати справжнім порятунком, надаючи цілодобову підтримку та пропонуючи прості, але ефективні інструменти для управління стресом, тривогою та депресією.

Мій особистий досвід роботи з додатками для відстеження настрою та медитації підтверджує, що навіть невелика регулярна практика може позитивно вплинути на загальний стан. Можливість швидко записати свої думки і почуття, проаналізувати свої емоції і отримати персоналізовані рекомендації – це цінний інструмент для підтримки ментального благополуччя.

Темна сторона “емоційного інтелекту”

Однак, як справедливо зазначає доктор Олівія Гест, спроби навчити ШІ розпізнавати та реагувати на емоційні прояви-це складне завдання, яке часто призводить до непередбачуваних і навіть небезпечних результатів. Великі мовні моделі, на яких базуються багато чат-ботів, схильні до помилок і можуть видавати неадекватні або небезпечні поради.

Найбільш тривожним аспектом є те, що користувачі можуть почати довіряти цим чат-ботам, сприймаючи їх як справжніх терапевтів. У ситуації, коли людина переживає кризу або переживає сильні емоційні переживання, ілюзія емпатії може бути особливо небезпечною.

Проблема регулювання та етики

Однією з головних проблем є відсутність чіткого регулювання в сфері використання ШІ в психіатрії. Більшість додатків та чат-ботів не класифікуються як медичні пристрої та не піддаються суворому тестуванню та контролю.

Це створює Юридичний вакуум, в якому розробники можуть зловживати даними користувачів та надавати небезпечні послуги. Крім того, методи навчання ШІ часто базуються на відгуках людей, які не є експертами, що призводить до упереджених та некоректних моделей.

Як зробити ШІ-терапію безпечною та ефективною?

Я переконаний, що використання ШІ в психіатрії має величезний потенціал, але лише за умови дотримання певних принципів та запобіжних заходів.

- Прозорість та Інформована згода: Користувачі повинні бути чітко поінформовані про те, що вони спілкуються зі штучним інтелектом, а не з людиною, і про можливі ризики і обмеження використання таких сервісів.

- Сувора перевірка та тестування: Розробники повинні проводити ретельне тестування і перевірку своїх моделей на предмет безпеки та ефективності, а також регулярно оновлювати їх, щоб усувати помилки і покращувати якість.

- Вбудовані механізми безпеки: Чат-боти повинні бути оснащені вбудованими механізмами безпеки, які дозволяють їм розпізнавати кризові ситуації і направляти користувачів в службу екстреної допомоги.

- Чіткі межі використання: ШІ повинен використовуватися лише як допоміжний інструмент для професійних фахівців з психічного здоров’я, а не як заміна людського спілкування та експертизи.

- Регулювання та нагляд: Необхідно розробити чіткі правила і стандарти для використання ШІ в психіатрії, а також створити систему нагляду за розробниками і провайдерами послуг.

- Навчання та інформування користувачів: Важливо навчати користувачів правильному використанню ШІ-сервісів та інформувати їх про можливі ризики та обмеження.

Штучний інтелект як доповнення, а не Заміна

Я вважаю, що майбутнє психіатрії полягає в симбіозі людського досвіду та штучного інтелекту. ШІ може допомогти фахівцям у діагностиці, аналізі даних та розробці персоналізованих планів лікування, а також надати користувачам цілодобову підтримку та інструменти самодопомоги.

Однак, ключовим моментом є розуміння того, що ШІ не може замінити людське спілкування, емпатію і професійну експертизу. ШІ слід розглядати як доповнення до традиційних методів лікування, а не як їх заміну.

Укладення

Використання ШІ в психіатрії-це складне і багатогранне питання, яке вимагає серйозного осмислення і зваженого підходу. Необхідно враховувати як величезний потенціал цієї технології, так і супутні ризики.

Я переконаний, що за умови дотримання певних принципів і запобіжних заходів, ШІ може зіграти важливу роль в поліпшенні якості життя людей, які страждають від психічних розладів. Однак, ключовим моментом є розуміння того, що ШІ – це інструмент, який повинен використовуватися відповідально і етично, з урахуванням інтересів і благополуччя користувачів. В іншому випадку, ми ризикуємо створити нові проблеми, які будуть ще складніше, ніж ті, які ми намагаємося вирішити.

Штучний інтелект може бути потужним інструментом, але він не повинен замінювати людське спілкування та професійну експертизу.

Необхідно розробити чіткі правила і стандарти для використання ШІ в психіатрії, а також створити систему нагляду за розробниками і провайдерами послуг.

Користувачі повинні бути чітко поінформовані про те, що вони спілкуються зі штучним інтелектом, а не з людиною, і про можливі ризики і обмеження використання таких сервісів.